数据中心转型

芯片采购网专注于整合国内外授权IC代理商现货资源,芯片库存实时查询,行业价格合理,采购方便IC芯片,国内专业芯片采购平台。

NVIDIA BlueField DPU (数据处理器)可用于加速网络功能。这种网络卸载可以使用 DPDK ,也可以用 NVIDIA DOCA 软件框架。

在本系列中,我构建了一个应用程序,并以两种方式卸载:DPDK 和 NVIDIA DOCA SDK 。我将每个步骤记录为单独的代码补丁,并在每个系列中提供完整的步骤。这部分将向您展示如何使用它 DPDK 编程 BlueField DPU 。

用例

首先,我需要一个简单但有意义的用例 DPU 上部署应用程序。我选择了基于策略的路由( PBR )来根据第 3 层和第 4 层数据包属性将流量引导到不同的网关,覆盖(或补充) X86 主机选择的网关。现实世界中需要这样做的原因有很多,包括以下示例:

· 将选定的主机流量发送到外部防火墙进行额外审核

· 增强 Anycast 负载平衡服务器

· 应用 QoS

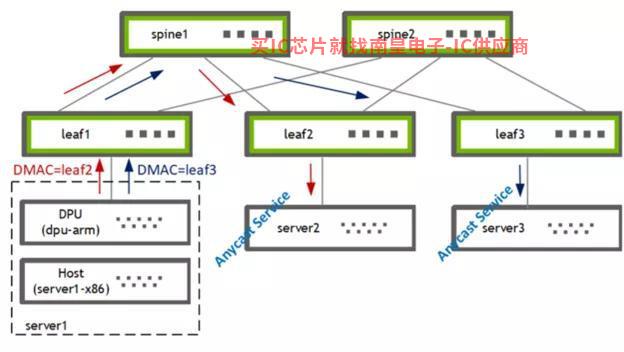

图 1 . 使用 PBR 将流量从主机引导到两个网关之一

我在 DPU (BF2-ARM)上使用 PBR 流量来自主机( server1-x86 )引导两个网关 [leaf2, leaf3] 其中之一。叶交换机随后将流量转发给当地连接的选播服务提供商 [server2, server3] 。

构建应用程序

第一个问题:我是写一个新的应用程序,还是卸载一个现有的应用程序?

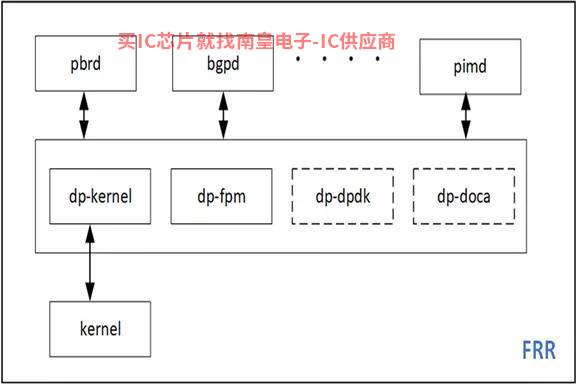

我决定卸载我最喜欢的开源路由软件栈 FRRouting ( FRR )的 PBR 功能。这使我能够扩展现有的代码库和现有的代码库 sample apps 形成良好的对比。FRR 支持多种数据平面插件的框架可以轻松使用 DPDK 和 DOCA 实现新的数据平面插件并集成到 FRR 。

图 2 . DPDK 和 DOCA 插件可以很容易地添加到 FRR中

DPU 应用程序原型

本节将介绍创作 DPU 应用程序需要准备硬件加速功能。

DPU 硬件

我有一个 x86 服务器安装在上面 BlueFied-2 DPU , 该 DPU 有两个 25G 上行链路和一个带 8GB 内存的 ARM 处理器 。更多关于硬件安装的信息,请参考 DOCA SDK 文档 。也可使用 DPU PocKit 构建和引导您的系统环境.

我安装了 BlueField 启动流文件( BFB ),它为 DPU 提供了 Ubuntu 操作系统图像附带 DOCA-1.2 和 DPDK-20.11.3 的库。

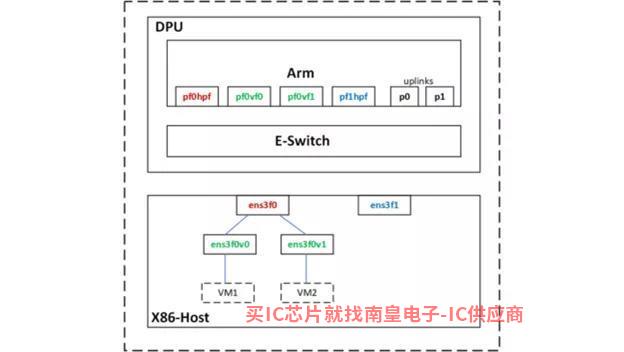

图 3 . Netdev Representors

使用 SR-IOV ,我在主机上为两台虚拟机创建了两个虚拟函数( VF )接口。

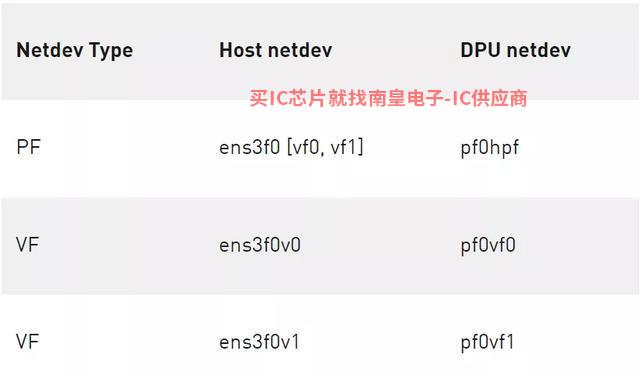

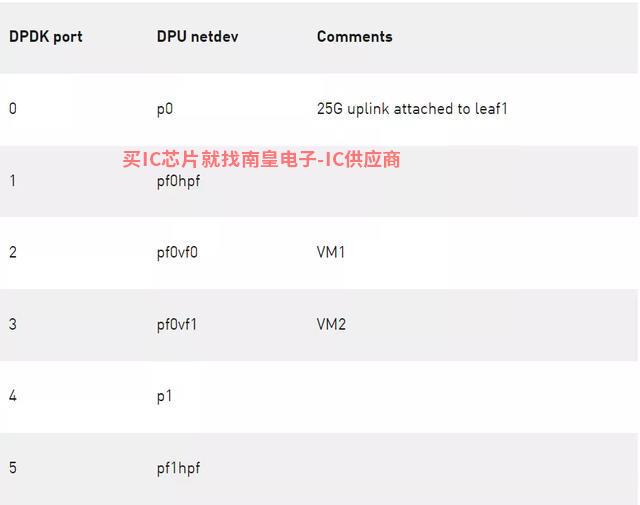

主机上的 PF 和 VF 分别映射到 DPU ARM 上的以下 netdev representors 。

表 1 .主机上 PF 和 VF 的映射

使用 DPDK testpmd 原型设计应用程序

首先,我用 DPDK 的 testpmd 我的用例原型化设计,位于 DPU 的 / opt / mellanox / 目录下。

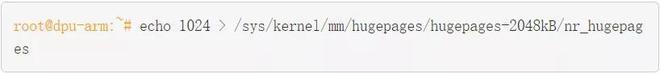

包括 testpmd 在内的任何 DPDK 必须设置所有应用程序 hugepages 。

(可选)保留配置,使其在 DPU 重启后仍然有效。

启动 testpmd 。

Testpmd 会消耗更多的内存,默认情况下会分配 3.5 GB 。因为我不需要在那里 CPU 处理数据流量时,我会 total-mem 的值设定为 200M ,其中 total-mem = total-num-mbufs * mbuf-size (默认 mbuf-size 为 2048 字节)。我还使用了 flowMarvell代理-isolation 模式,因为我必须 ARP 数据包发送到 DPU 内核网络堆栈分析 PBR 下一跳)。初始化完成后,-i选项使得 testpmd 进入交互式 shell 。

作为 testpmd 完成 rte_eal 初始化的一部分, mlx5_pci 被探测并成为可访问的设备 DPDK 端口。

你在这里看到的 DPDK 端口对应 PF / VF representor 和两个上行链路。

表 2 . DPDK 端口映射

流创建

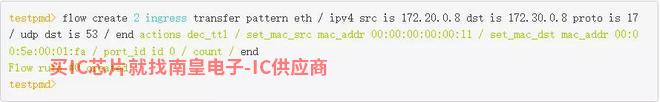

接下来,通过定义 ingress port 、源 IP 、目标 IP 、我用协议和端口 rte_flow 下发了PBR规则。此外,我还定义了匹配数据包采用的方法 ACTION 。源 MAC 和目标 MAC 被重写, TTL 出口端口设置为物理上行链路 p0 。

这条 PBR 规则从 VM1接收 DNS 并将其发送到特定的流量 GW ( leaf2, server2 )。我还故障定位,我还增加了一个计数器。

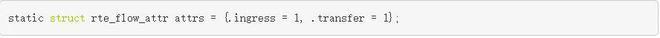

DPU 卸载可以工作 Switch ( FDB )模式,也可以工作 NIC 模式。在这个用例中,经过几次数据包修改,我需要将流量从 X86 主机重定向 25G 上行链路。所以在概念上,这里使用 Switch ( FDB ) 因此,需要设置模式 rte_flow 的 transfer 属性。

流程验证

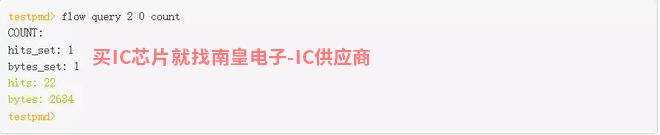

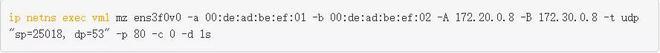

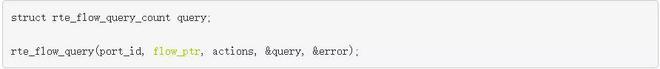

我从 VM1 发送一些流量,看看它是否与我一起使用 testpmd 创建的 flow 通过执行是否匹配 query 命令来查看。

结果是匹配的,在 leaf2/server2 这些流量和修改后的数据包头可以在上面看到。因为操作流量是 DNS ,所以为了测试流量,我从 VM1 发送 DNS 请求。我使用它来控制流量速率和其他数据包字段 mz 生成测试流量。

另一种健全检查是检查此流是否真的卸载。这样做有两种方法:

· 在 Arm CPU 上使用 tcpdump 确保内核不接收此类数据包。

· 检查硬件 eSwitch 是否有相应的流量规则。

mlx_steering_dump 允许您在硬件上查看成功的流量规则。 git 下载并安装工具。

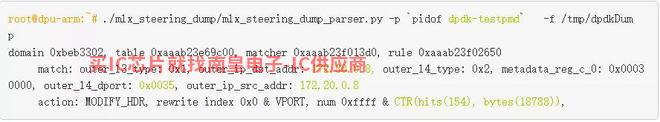

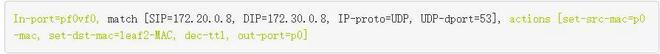

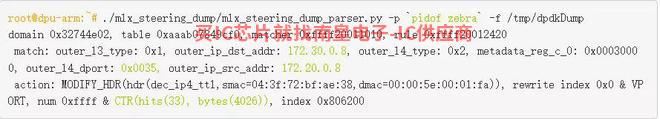

使用 mlx_steering_dump_parser.py 脚本验证硬件中发布的流量规则。

此命令打印出来 testpmd 应用程序发布的所有流程规则。硬件上设置的外部可以看到 头部匹配信息和前面RTE_FLOW定义的匹配 [SIP = 172.20.0.8 , DIP = 172.30.0.8 , IP proto = UDP , UDP dport = 53] 是一致的。流量计数器的值作为打印输出的一部分也被读取和重置。

作为应用程序设计思维过程的最后一步,原型设计已经完成。现在我知道我可以了 DPDK 中建立一个 PBR 规则,将其安装在硬件中,并修改我们感兴趣的数据报告。现在在下一节添加 DPDK 数据平面。

构建 DPDK 数据平面插件

在这一节中,我将通过方向 Zebra 添加一个 DPDK 介绍数据平面插件 DPU 对 PBR进行 硬件加速步骤。我将这些步骤分解为单独的代码提交,整个补丁集 reference 提供形式。

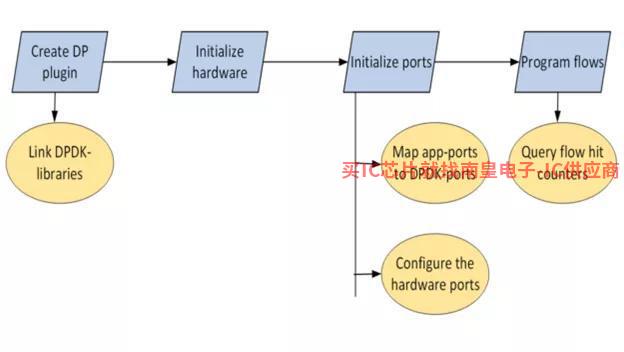

图 4 .路由基于策略 DPDK 卸载工作流

开发环境

因为目标体系结构是 DPU Arm ,所以可以直接在那里 DPU Arm上构建、在 X86 CPU 交叉编译或在云中构建。在这篇文章中,我直接在那里 DPU Arm 编码构建。

以 root 用户身份操作应用程序

FRR 通常作为非 root 用户运行。FRR 整个互联网路由表可以下载和上传;这可能有什么问题?然而,几乎所有人 DPDK 应用程序都是以 root 用户身份操作, DPDK 库和驱动程序也是基于此设计的。

经过多次实验并使用 root 重新编译用户选项 FRR, 我还是放不下 FRR 作为非 root 用户工作。这是可以接受的,因为我在一个安全的空间,即 DPU Arm 中运行 FRR 。

向 Zebra 添加新插件

Zebra 是 FRR 其中一个守护过程负责整合路由协议守护过程的更新和构建转发。Zebra 还有一个基础设施可以将这些转发表送到图像 Linux 内核等数据平面。

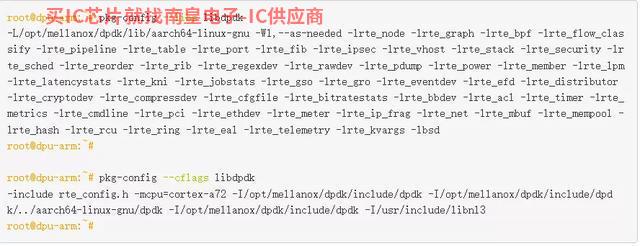

将 DPDK 共享库链接到 zebra

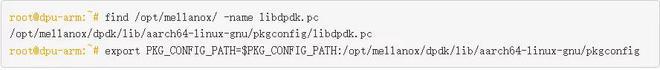

FRR 有自己的构建系统,限制直接导入外部 make 文件。由于 pkg-config 简单优雅,链接相关库 Zebra 很容易。

我找到了 libdpdk.pc 并添加 PKG_CONFIG_PATH 值中:

FRR 有自己的构建系统,限制直接导入外部 make 文件。由于 pkg-config 简单优雅,链接相关库 Zebra 很容易。

我找到了 libdpdk.pc 并添加 PKG_CONFIG_PATH 值中:

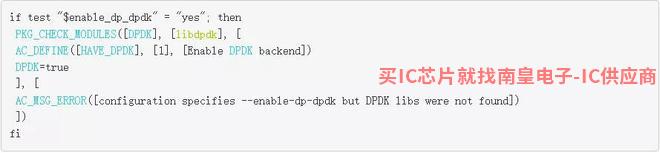

我在 FRR makefile (configure.ac)中为 DPDK 添加了 pkg check-and-define 宏。

我将 DPDK libs和cflags抽象包含在zebra-dp-dpdk make 宏( zebra/subdir.am )中。

有了这些,我就有了构建插件所需的所有头文件和库。

初始化硬件

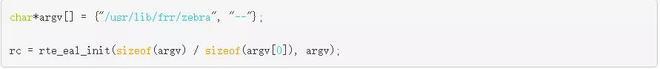

第一步是硬件的初始化。

这将探测 PCIe 设备并填充 DPDK rte_eth_dev 数据库。

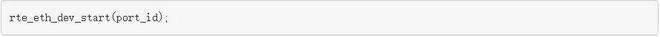

初始化端口

然后设置硬件端口。

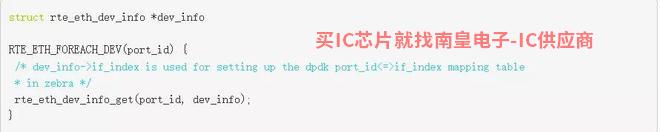

端口映射设置应用程序

FRR 有自己的基础 Linux netdevs 使用表的接口(端口)表 NetLink 更新填充并使用 ifIndex 索引键值。PBR 将规则锚定到表中的一个接口。要编程 PBR 数据平面条目需要一个 Linux ifIndex 和 DPDK port-id 值之间的映射表。netdev 信息已经在 DPDK 可用于驱动程序 rte_eth_dev_info_get 查询。

配置硬件端口

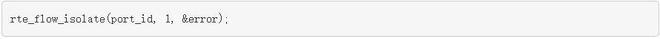

此外,所有端口都需要放置 flow-isolation 并启动模式。

Flow-isolation 该模式将未命中的数据包发送到核心网络堆栈,允许其处理 ARP 请求等等。

使用 rte _流 API 编程 PBR 规则

PBR 现在需要使用规则 rte_flow 以下是一个例子规则:

通过这些参数 rte_flow_attributes 、 rte_flow_item ( match ) 和 rte_flow_action 填充数据结构。

流属性

该数据结构用于指示 PBR 流量用于分组重定向或 transfer flow 。

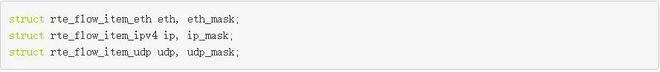

流匹配项

DPDK 使用数据包头中的每一层 {key, mask} 匹配结构:以太网, IP 、 UDP 等。

填写这些数据结构需要大量的重复代码。

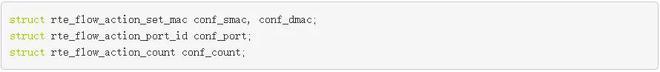

流动作

DPDK 为每个 Action 使用单独的数据结构,然后允许您以可变长度数组的形式提供所有流量规则 Actions 。有关 Actions 如下:

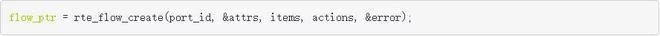

验证和创建流程

您可以验证可选项 rte_flow_attr、rte_flow_item 和 rte_flow_action 列表。

验证通常用于检查底层 DPDK 驱动程序是否支持特定的流配置。在最终代码中,您可以直接跳转到流创建。

Rte_flow 命令锚定到输入端口。可以创建多个流条目组并链接这些组。即使流条目没有链的第一组,也就是不在组中 0 它仍然必须锚定到输入端口。group-0 性能限制存在。

流量插入率为 group-0 受限制。绕过这个限制,你可以 group-0 安装默认流,跳转到 group-1 ”,然后在 group-1 创建流量规则。

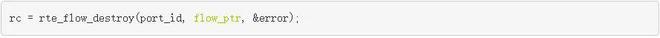

流删除

流创建 API 返回流指针,必须缓存后续流删除。

FRR-PBR 分析保护过程管理状态机,添加或删除 PBR 因此,我不必使用它。 DPDK 衰老的原始函数 PBR 规则。

流量统计

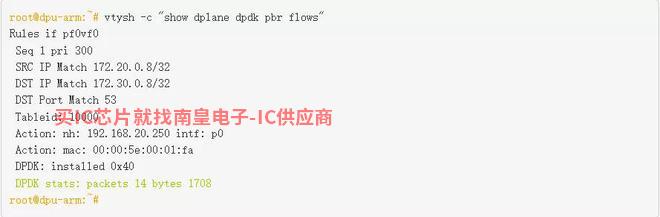

在创建流量时,我将计数操作附加到流量中。可用于查询流量统计信息和命中次数。

为了便于测试和验证,我插入了统计显示 FRR 的 vtysh CLI 。

测试应用程序

我以 root 启动了用户身份 FRR ,并通过 /etc/frr/daemons 新添加的文件启用 DPDK 插件:

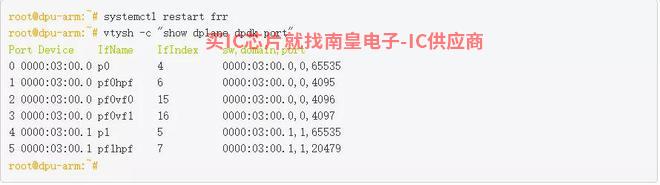

DPDK-port 映射表的 FRR 接口已填充:

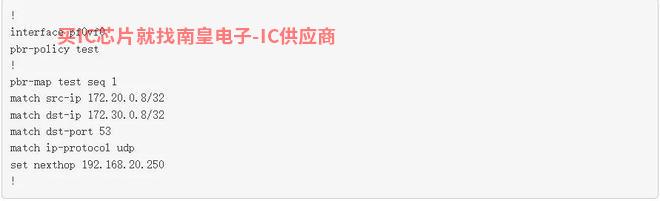

接下来,我会 PBR 来自匹配的规则配置 VM1 的 DNS 并使用流量 frr.conf 重定向 leaf2 。

我从 VM1 发送 DNS 查询到 anycast DNS 服务器。

匹配流量,并使用修改后的数据包头将流量转发到目的地 leaf2/server2 。这可以连接到流的计数器并使用 mlx_steering_dump 验证硬件转储。

FRR 现在功能齐全了 DPDK 可用于数据平面插件 DPU 硬件上卸载 PBR 规则。

总结

本文回顾了使用情况 DPDK RTE_FLOW库在 BlueField 上硬件加速 PBR 规则的 FRR 创建数据平面插件。在下一篇文章中,我将带您了解 FRR DOCA 数据平面插件,并向您展示如何使用新的 DOCA_FLOW 库卸载 PBR 规则。

- 让我们回顾一下河北开发者中心研究社华为云数字人第一期的专题活动

- ST先进SiC牵引电机逆变器解决方案

- 美媒:苹果将在iPhone用户能接受更多的广告吗?

- 三点思考,通过软件给合作移动机器人更多的智能

- 贸泽电子销售Wi-Fi 6设计的Qorvo QPF4532集成前端模块

- 佳能将于2023年上半年发售3D半导体光刻机的曝光面积是目前的4倍

- 英特尔开源SYCLomatic帮助开发者创建异构代码的迁移工具

- 国产芯片发布芯片教材 为中国未来培养工程师

- 飞行车后,小鹏又烧钱做机器人了!为什么汽车公司喜欢做副业?

- 迎接人机合作的未来,就在今天!

- 美欲组芯片四方联盟包围中国

- 350W AC/DC超窄壳开关电源—— LMF350-23BxxUH