Nvidia在其年度GTC会议宣布了一系列AI是重点企业产品。它包括其新的硅结构Hopper第一个使用该架构的数据中心GPU H100;一个新的Grace CPU "超级芯片";该公司声称将建立世界上最快的AI超级计算机的模糊计划被称为Eos。

芯片采购网专注于整合国内外授权IC代理商现货资源,芯片库存实时查询,行业价格合理,采购方便IC芯片,国内专业芯片采购平台。

Nvidia从过去十年的人工智能热潮中受益匪浅GPU数据密集型深度学习方法被证明是流行的完美匹配。Nvidia表示,随着AI该领域对数据计算需求的增长希望提供更多的火力。

特别是,该公司强调了机器学习系统的普及,称为变形金刚。为从OpenAI的GPT-三等语言模型DeepMind的AlphaFold等待医疗系统提供动力。这类模型的规模在几年内呈指数级增长。例如,当OpenAI在2019年推出GPT-2.它包含15亿参数(或连接)。两年后谷歌训练类似模型时,使用了1.6万亿参数。

随着AI要求更多的计算机,Nvidia希望提供它

"训练这些巨型模型仍然需要几个月的时间,"Nvidia高级产品管理总监Paresh Kharya在新闻发布会上说。"所以你解雇了一份工作,等了一个半月,看看会发生什么。缩短训练时间的心的增加,缩短训练时间的一个关键挑战是GPU性能收入的数量开始下降。"

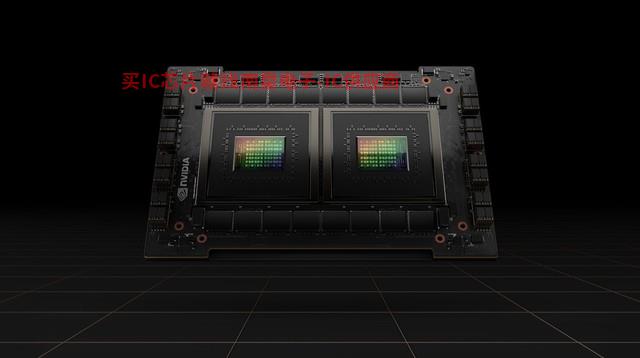

Nvidia表示,新的Hopper架构将有助于改善这些困难。该架构是计算机科学家和美国海军少将的先驱Grace Hopper与上一代芯片相比,该架构是专门用于命名的H100 GPU新的第四代加速变形金刚模型的训练Nivida NVlink多达256可连接H100 GPU,带宽是上一代的9倍。

H100 GPU它本身包含800亿晶体管,是第一个支持PCle Gen5和利用HBM3的GPU,使内存带宽达到3TB/s。Nvidia表示,H100 GPU在FP16、FP32和FP与上一代相比,64计算方面与上一代相比A100快三倍,8位浮点数学快六倍。

"训练巨型变形金刚模型,H过去几周的训练将提供高达9倍的性能,"Kharya说。

该公司还宣布了一个新的数据中心CPU--Grace CPU有两个超级芯片CPU通过,通过新的低延迟NVLink-C2C直接连接。该芯片旨在与新的基础相结合Hopper的GPU一起 "服务于巨型HPC和AI应用",并可用于纯CPU系统或GPU加速服务器。它有144个Arm核心和1TB/s内存带宽。

新的格雷斯CPU "超级芯片 "由两个CPU连接而成。

除硬件和基础设施新闻外,Nvidia它还宣布了各种企业人工智能软件服务的更新,包括Maxine(提供音频和视频增强功能SDK,和Riva(用于语音识别和文本语音转换SDK)。

该公司还预测,它正在建造一台新的人工智能超级计算机,声称它将是世界上最快的部署。这台名为Eos将采用超级计算机Hopper结构包括约4600个H100 GPU,提供18.4 exaflops的 "AI性能"。该系统将只用于Nvidia该公司表示,内部研究将在几个月后上线。

在过去的几年里,一些对人工智能感兴趣的公司成立或宣布了自己的内部 "超级人工智能计算机",微软、特斯拉和Meta。由于其运行精度低,这些系统与普通超级计算机没有直接的可比性,这使得一些公司能够通过宣布世界上最快的超级计算机快速跨越。

然而,在他的主题演讲中,Nvidia首席执行官黄仁勋的确CotoTechnology代理实表示,Eos275 petaFLOPS的计算量--比 "美国最快的科学计算机"(Summit)快1.4倍。"我们期望Eos成为世界上最快的人工智能计算机,"黄说。"Eos会成为我们的OEM和云合作伙伴最先进AI基础设施蓝图"。

- 小米印度公司负责人责人 ,擢升 COO 穆拉里什南是总裁

- 如何影响半导体?

- 三星将为巴西购买Galaxy Z Fold 4/Flip 4用户提供充电器

- 研华携手Basler及Canonical 探索机器人发展的三个关键要素

- CITE2022年观众登记全面开放,享受VIP观众只需一步!

- 自动驾驶卡车可以缓解供应链问题

- 厉害!龙芯国内自研GPU芯片实现0突破

- 摩尔定律不会死 台积电已计划1nm工艺:下代EUV光刻机是关键

- 不愧为战斗民族 俄罗斯决定跳过5G开发6G网络

- 英伟达不想要地平线

- 太多的订单无法生产?特斯拉在亚洲和欧洲停止销售Cybertruck

- 贸泽电子与Phoenix Contact微网站宣布推出新的储能设备解决方案